2025年DeepSeek太火爆服务器崩了,经常是服务器繁忙,请稍后再试,如何解决?把DeepSeek部署到本地可以一键解决,断网也能用,或者基于第三方云计算如阿里云、腾讯云、京东云等厂商安装DeepSeek,目前主流云厂商都已经支持DeepSeek一键部署。本文服务器百科网fwqbk.com整理一招解决DeepSeek服务器繁忙,拒绝稍后再试,及时行乐,愿意试你们试吧!

DeepSeek服务器繁忙

安装Ollama

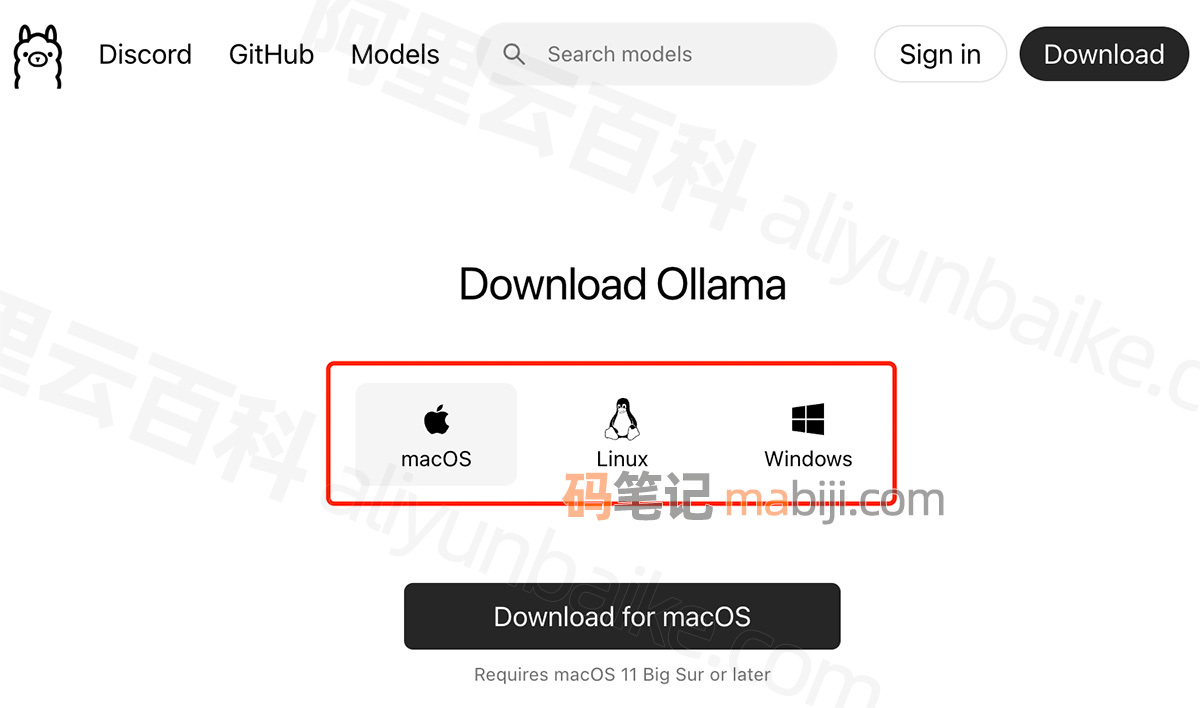

打开Ollama官网:https://ollama.com/ 点击“Download”,如下图:

本地电脑安装Ollama

根据你本地电脑的操作系统类型下载对应的Ollama版本,目前Ollama支持macOS、Linux和Windows主流操作系统。关于Ollama的下载和安装,码笔记就不多赘述。

如果本地电脑配置不够,也可以基于第三方云厂商来部署安装DeepSeek,纯傻瓜教程,零代码部署:

运行Ollama

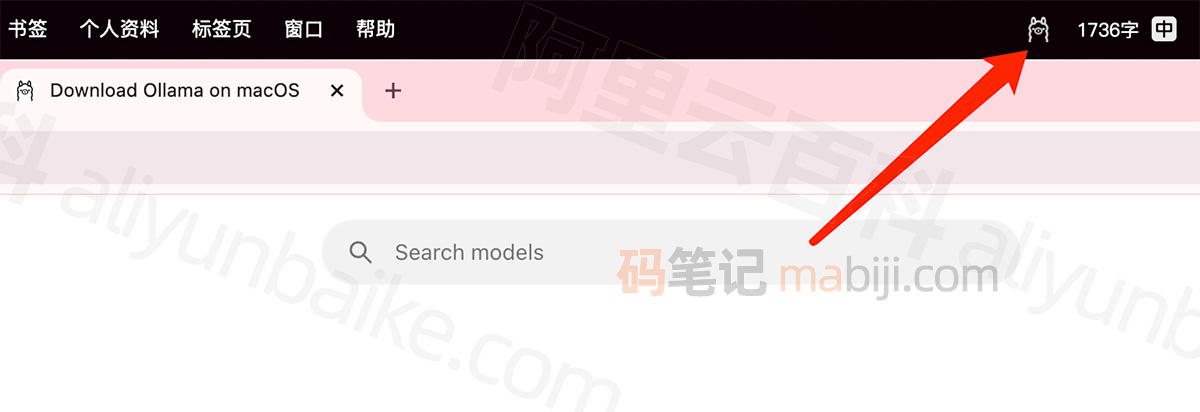

打开Ollama,只需要确保你的电脑上已经运行Ollama即可。以Mac为例,在顶部菜单栏中看到这个小羊驼的图标即可,如下图:

打开并运行Ollama

Ollama官网搜索deepseek

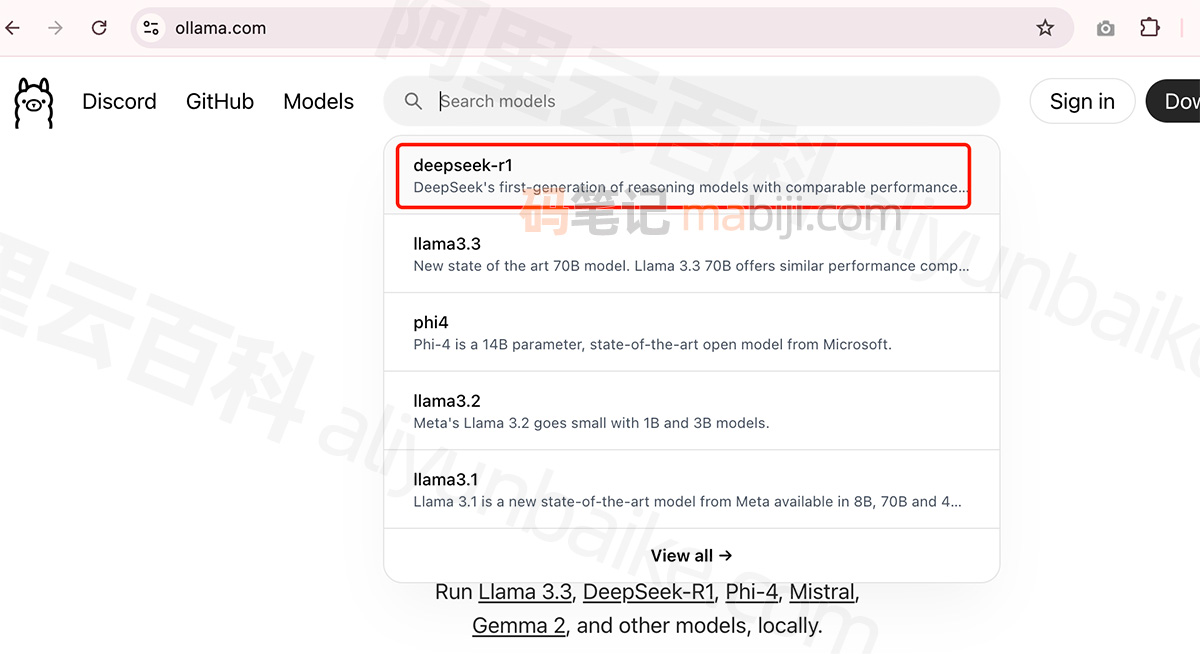

打开Ollama官网:https://ollama.com/ 搜索“deepseek”,如下图:

deepseek-r1大模型

选择deepseek-r1不同模型大小

点击deepseek-r1,你会发现有多个不同大小的模型版本,如1.5b、7b、8b、14b、32b、70b或671b,模型大小不同,可适配的电脑显存、显卡及内存配置也不同,大家可以参考下表,根据配置选择不同大小的模型,参考:deepseek-r1的1.5b、7b、8b、14b、32b、70b和671b有啥区别?

如何运行模型?

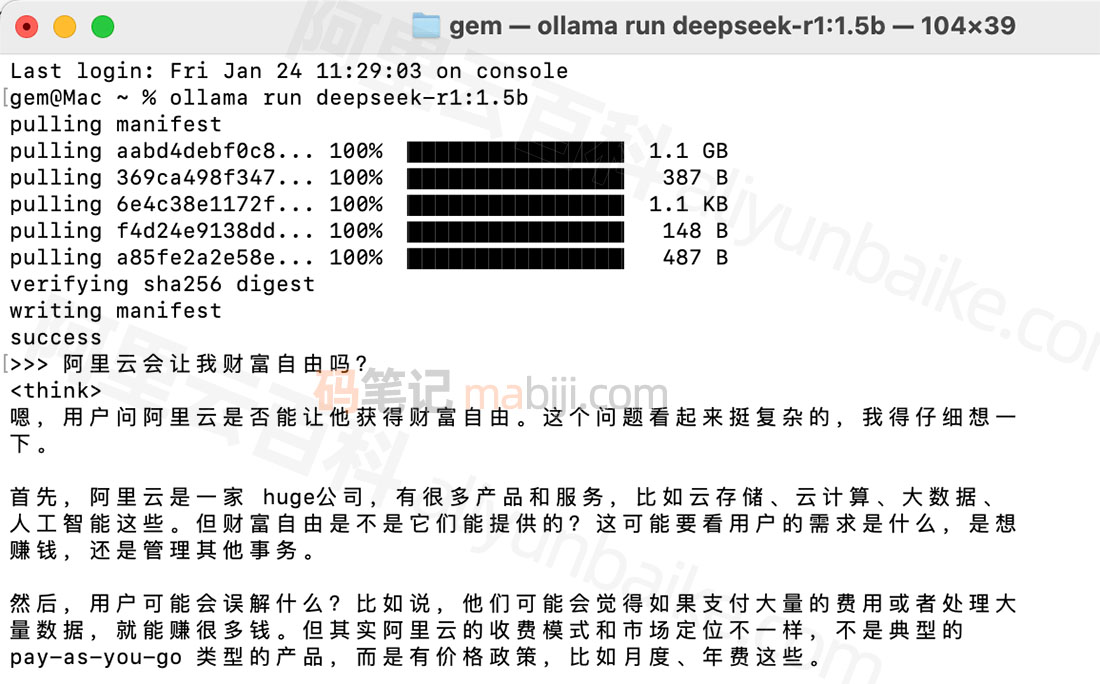

如何运行deepseek?运行模型很简单,确定好想要的模型后,复制对应的命令到你的终端并执行。

DeepSeek-R1-Distill-Qwen-1.5B:

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B:

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B:

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B:

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B:

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B:

ollama run deepseek-r1:70b

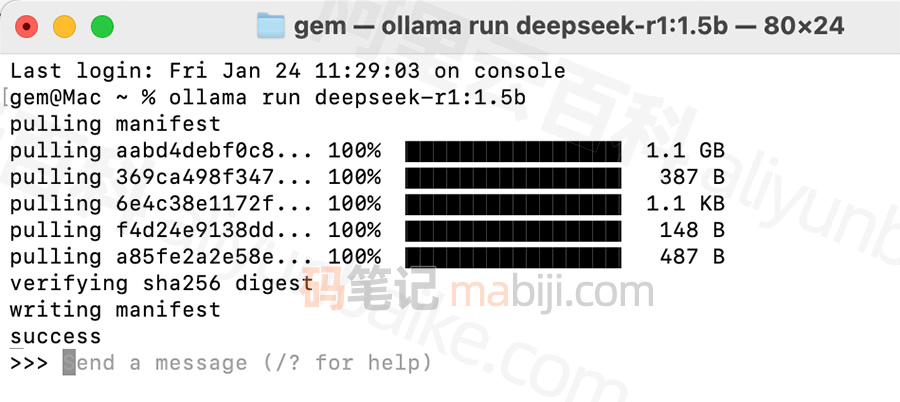

码笔记以1.5B为例,复制 ollama run deepseek-r1:1.5b 在终端粘贴并执行,然后等待进度条pulling manifest下载100%,如下图:

DeepSeek pulling manifest

然后就可以开始折腾了,例如在终端输入“阿里云会让我财富自由吗?”

阿里云会让我财富自由吗?

如果想退出模型,在终端输入/bye即可。

本文关于DeepSeek的教程,是基于Ollama这个大模型运行框架,更多关于Ollama的命令操作,请参考上网搜索Ollama终端指令,本文不多赘述。

- 阿里云官方活动 https://t.aliyun.com/U/bLynLC

- 腾讯云官方优惠 https://curl.qcloud.com/oRMoSucP

- 京东云服务器 https://jdyfwq.com/

- 百度云服务器 https://bdyfwq.com/

- 华为云服务器 https://hwyfwq.com/